Bienvenue dans la deuxième édition de la deuxième saison de ZtoA Pulse.

À l’ère du numérique, où chaque frappe et chaque transaction génèrent des données, il est essentiel d’en exploiter la puissance. Au cœur de cette transformation se trouve la fusion des connaissances et de l’expertise, où les pionniers de la connaissance croisent les pionniers de la technologie. C’est précisément ce que cette édition contient – une lettre d’information qui associe l’expertise des leaders d’opinion de Zuci Systems à des informations tirées de l’un des récents rapports de Gartner sur les données et l’analyse.

Avec un œil attentif sur l’horizon, nous avons conçu cette lettre d’information pour décoder l’avenir des données et de l’analyse à l’aide des lentilles fournies par Gartner. Leur récent rapport, intitulé “Over 100 Data and Analytics Predictions Through 2028” (lien ci-dessous), sert de balise aux organisations pour qu’elles mettent à l’épreuve leur cadre de données et d’analyse.

Cette lettre d’information se penchera sur quatre prédictions, en recherchant les points de vue de nos experts et en démêlant les différentes couches pour enrichir le discours. Ensemble, nous remettrons en question les hypothèses, susciterons des conversations et jetterons un pont entre les aspects théoriques et pratiques des prévisions de Gartner en matière de données et d’analyse.

Présentation des experts du système Zuci :

1) Kalyan Allam

Bonjour à tous, je suis Naresh Kumar, Lead Marketing Strategist chez Zuci Systems. Découvrons les quatre prédictions de Gartner qui contribuent à façonner le jeu des données et de l’analyse des organisations !

Prédiction 1 – D’ici 2026, 50 % des outils de BI activeront les métadonnées de leurs utilisateurs, offrant des informations et des récits de données avec des recommandations de parcours et d’actions contextualisés.

Déménagement à Kalyan Allam

Naresh : Quels sont les principaux avantages que les organisations et les utilisateurs peuvent attendre des outils de BI qui proposent des recommandations de parcours et d’actions contextualisés ?

Kalyan : En règle générale, les décideurs cherchent constamment des réponses à des questions récurrentes, alors que les données elles-mêmes sont en constante évolution. Le récit qu’ils cherchent à construire à partir des données change au fur et à mesure que les circonstances évoluent. Ainsi, le désir d’obtenir des informations personnalisées a été difficile à réaliser pour les organisations.

Cependant, l’extraction de ces informations à partir de diverses sources de données reste un obstacle. Ces difficultés perdurent parce que chaque personne s’engage dans un ensemble particulier de données et les comprend à sa manière, ce qui donne lieu à des récits différents. Ce scénario souligne l’importance des informations personnalisées, qui sont extrêmement précieuses. Pour atteindre cet objectif, les organisations doivent rassembler les métadonnées des utilisateurs.

Il est essentiel de développer des systèmes qui documentent les parcours analytiques des utilisateurs et comprennent l’intention qui sous-tend chaque demande. Ce concept d’analyse basée sur les acteurs sera très bénéfique pour les organisations, et ce à de nombreux égards.

Naresh : Pourriez-vous nous éclairer sur la manière dont les organisations tirent profit des analyses basées sur les acteurs et des informations personnalisées ?

Kalyan : Bien sûr, Naresh. C’est une excellente question.

Les organisations peuvent notamment bénéficier d’analyses basées sur les acteurs et d’informations personnalisées :

1. Engagement accru de l’utilisateur : La fourniture d’informations personnalisées favorise un niveau élevé d’engagement de la part des utilisateurs, les incitant à participer activement et à interagir plus fréquemment avec l’outil de veille stratégique (BI). Cet engagement accru découle de la pertinence et de la spécificité des informations, qui répondent plus efficacement aux besoins et aux objectifs de chaque utilisateur.

2. Atténuation de la surcharge cognitive : En fournissant des informations personnalisées, les entreprises réduisent la charge cognitive en fournissant des informations correspondant précisément aux intérêts des utilisateurs. Cette approche permet aux utilisateurs de se concentrer sur les processus de prise de décision.

3. Allocation optimisée des ressources : La connaissance des parcours analytiques des utilisateurs permet aux entreprises d’allouer leurs ressources de manière optimale. En discernant les modèles et les préférences qui émergent des interactions avec les utilisateurs, les organisations peuvent orienter les investissements vers les domaines qui promettent l’impact et la valeur les plus significatifs, ce qui permet d’améliorer l’efficacité et de maximiser l’utilisation des ressources.

Naresh : Comment ces outils de BI identifient-ils et recommandent-ils des parcours et des actions contextualisés pertinents pour les utilisateurs ? Quels algorithmes ou méthodologies sont couramment utilisés pour adapter les informations aux besoins individuels ?

Kalyan : Actuellement, il y a une lacune dans la disponibilité de solutions prêtes à l’emploi qui peuvent fournir des informations personnalisées aux utilisateurs. Pour identifier un parcours contextualisé dans les outils d’intelligence économique (BI) et fournir des informations personnalisées aux utilisateurs, il est urgent de se concentrer sur deux aspects essentiels.

Naresh : Pourriez-vous nous présenter ces deux aspects ?

Kalyan : Tout d’abord, il est essentiel de saisir les métadonnées des utilisateurs. Il s’agit de recueillir des informations sur les rôles et les responsabilités de l’utilisateur, les ensembles de données spécifiques auxquels il accède et les questions qu’il pose. En capturant ces éléments de manière holistique, les organisations peuvent se faire une idée complète des profils des utilisateurs individuels, ce qui permet de créer des informations qui correspondent directement à leurs besoins et exigences uniques.

Deuxièmement, la convergence des technologies d’apprentissage machine (ML) (en particulier les grands modèles linguistiques tels que le GPT d’OpenAI et les LLM proposés par des plateformes comme Hugging Face) avec les outils de BI tels que Tableau ou Power BI peut faciliter le processus. Ces LLM possèdent la remarquable capacité de contextualiser les parcours des utilisateurs en saisissant leurs demandes et intentions spécifiques. Pour rendre ce modèle opérationnel, les organisations doivent mettre en place un système dans lequel le parcours analytique commence par des invites. Cette approche basée sur des messages-guides facilite la saisie des métadonnées des utilisateurs, ce qui permet au système d’apprendre en permanence et d’affiner ses informations en fonction de l’évolution des schémas d’interaction des utilisateurs.

En utilisant ces stratégies, les organisations peuvent ouvrir la voie à une approche transformatrice des informations personnalisées, en intégrant des technologies avancées de ML et des outils de BI, et finalement en améliorant l’expérience de l’utilisateur en fournissant des solutions analytiques précisément adaptées.

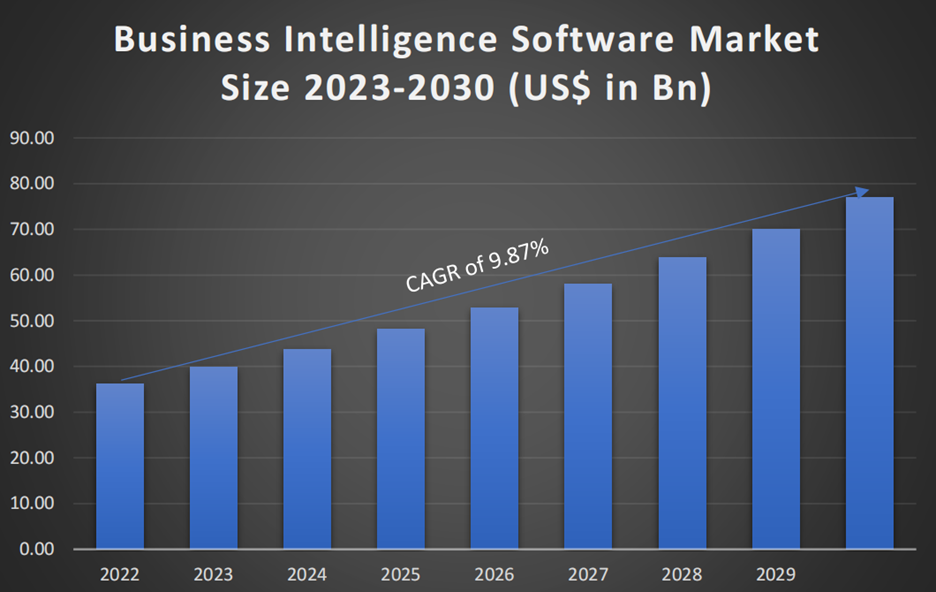

Selon SNS Insider Research, la taille du marché des logiciels de veille stratégique a été évaluée à 36,27 milliards de dollars US en 2022 et devrait atteindre 77,03 milliards de dollars US d’ici 2030, avec un taux de croissance de 9,87 % sur la période de prévision 2023-2030.

Prévision 2 : D’ici 2026, plus de 60 % des capacités de détection, d’investigation et de réponse aux menaces (TDIR) exploiteront les données de gestion de l’exposition pour valider et hiérarchiser les menaces détectées, contre moins de 5 % aujourd’hui.

Déménagement à Janarthanan Poornavel

Naresh : Comment l’IA et le ML jouent-ils un rôle dans l’analyse des données de gestion de l’exposition pour la détection et la réponse aux menaces ? Quels sont les principaux algorithmes et techniques d’apprentissage automatique utilisés dans ce contexte ?

Jana : J’aimerais évoquer l’une des réussites mettant en évidence l’intégration transparente de l’IA et de la ML, en ce qui concerne la gestion des données d’exposition et le TDIR, dans l’un de nos récents projets visant à lutter contre le défi complexe de la fraude aux chèques bancaires.

Compte tenu de la difficulté du problème, la recherche d’une solution parfaite dans un délai raisonnable a été un véritable défi. Dans notre cas, la complexité a été aggravée par l’augmentation exponentielle du volume des transactions. Comme vous pouvez l’imaginer, le nombre de transactions à analyser pourrait rapidement dépasser les approches traditionnelles, rendant difficile la détection d’activités potentiellement frauduleuses impliquant l’historique des transactions, le comportement des comptes et les modèles.

Cependant, l’intégration de l’IA et de la ML nous a aidés à analyser de vastes quantités de données, à reconnaître des modèles et à nous adapter à l’évolution des menaces, ce qui nous a permis de créer un formidable mécanisme de défense contre la fraude aux chèques. Grâce à la mise en œuvre réussie de la détection des menaces axée sur la gestion de l’exposition, les algorithmes d’IA ont rapidement évalué le comportement transactionnel pour identifier les anomalies susceptibles d’indiquer des activités frauduleuses visant un “nombre x” de pesos.

Naresh : Jana, vous avez expliqué comment l’IA et le ML ont été appliqués pour lutter contre la fraude aux chèques. Pourriez-vous expliquer comment l’apprentissage automatique offre des solutions possibles pour la gestion des données d’exposition dans le contexte de la détection des menaces ?

Jana : Bien sûr, Naresh. L’apprentissage automatique apporte des solutions robustes pour la détection des menaces. Permettez-moi d’aborder quelques aspects essentiels, à savoir la reconnaissance des formes et la détection des anomalies.

- Reconnaissance des formes : Les algorithmes d’apprentissage automatique excellent dans la reconnaissance des formes. Grâce à un entraînement rigoureux sur un ensemble de données variées de chèques manuscrits, les modèles ML deviennent capables de distinguer les altérations légitimes des altérations frauduleuses. Cette meilleure reconnaissance des formes accroît notre sensibilité aux anomalies les plus subtiles.

- Détection des anomalies : La ML permet de détecter des anomalies, c’est-à-dire des irrégularités qui pourraient passer inaperçues avec les méthodes traditionnelles. Les données relatives à la gestion de l’exposition constituent un trésor d’informations contextuelles. Nous nous appuyons sur des algorithmes ML pour découvrir les corrélations et les écarts cachés qui indiquent des menaces potentielles.

Naresh : Jana, votre histoire de réussite met en évidence la puissance de l’IA et du ML dans la détection des menaces. Pourriez-vous m’expliquer comment l’IA et le ML ont ouvert la voie à ce succès ?

Jana : C’est une excellente question.

Les algorithmes avancés d’apprentissage profond et la pile de services d’inférence ont joué un rôle important dans la détection des fraudes. Laissez-moi vous guider pas à pas :

Étape 1 – Notre équipe a utilisé des algorithmes d’apprentissage profond de pointe pour relever ce défi complexe. Ces algorithmes avancés, basés sur l’apprentissage automatique, reconnaissent des modèles et des anomalies dans de vastes ensembles de données. En entraînant ces modèles sur un large éventail de chèques manuscrits, nous avons pu améliorer la sensibilité et la spécificité, permettant ainsi d’identifier les altérations frauduleuses les plus subtiles.

Étape 2 – La banque comptant plus de 1 000 agences, nous avons mis en place un service d’inférence innovant afin de minimiser les fraudes aux chèques dans toutes les agences. Cette architecture nous a permis de traiter efficacement un immense volume de contrôles, en maximisant les capacités de nos modèles d’apprentissage profond. La combinaison de l’IA et d’une infrastructure efficace s’est avérée être une formule gagnante.

Naresh : C’est une approche intelligente, Jana. La façon dont vous avez exploité des algorithmes de pointe et une infrastructure évolutive pour relever efficacement le défi est impressionnante.

Jana : Dans le contexte de l’analyse des données de gestion de l’exposition pour la détection des menaces et la réponse à la fraude aux chèques, l’IA et la ML se sont révélées être des catalyseurs de transformation. Notre apprentissage en profondeur, enrichi de la puissance des algorithmes d’apprentissage automatique (Yolo et Faster CNN), nous permet de discerner les schémas frauduleux avec une précision sans précédent. En outre, notre pile de services d’inférence sophistiquée garantit que cette technologie avancée peut être déployée efficacement sur le réseau.

Naresh, pour conclure, je suis d’accord avec les idées de Gartner sur l’évolution du paysage de la détection des menaces. Leur prédiction selon laquelle plus de 60 % des capacités de détection des menaces exploiteront les données de gestion de l’exposition d’ici 2026 résonne avec notre approche. En intégrant les données relatives à la gestion de l’exposition, je prévois une croissance impressionnante de 15 % du TDIR, qui est de 5 % aujourd’hui.

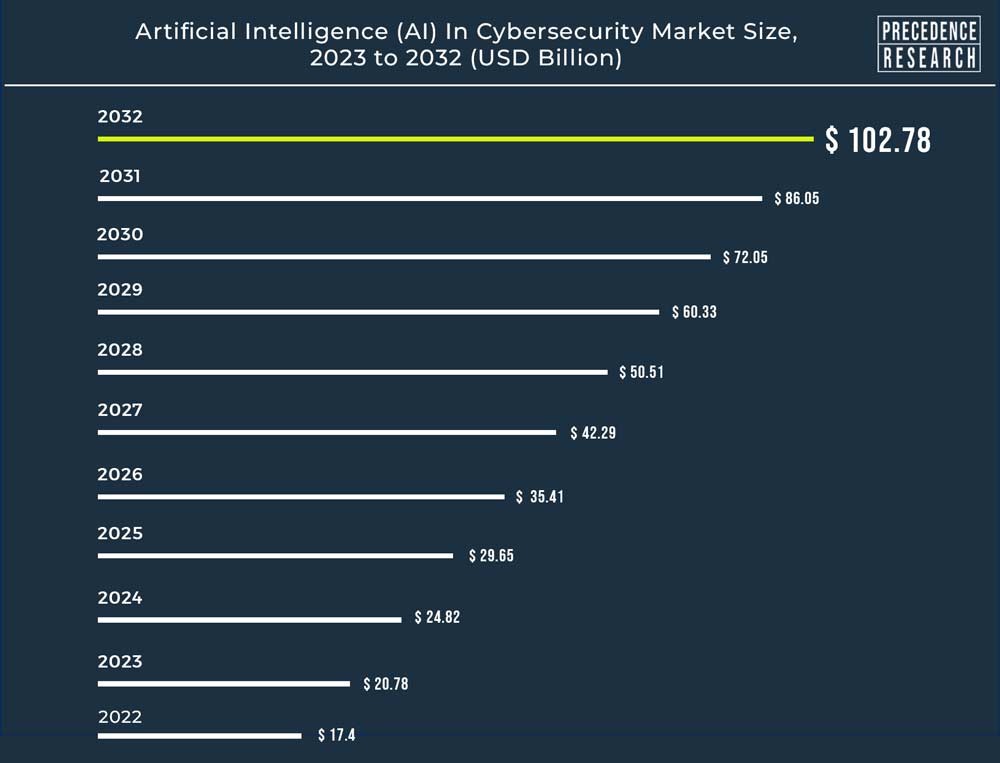

La taille du marché mondial de l’intelligence artificielle (IA) dans la cybersécurité a été évaluée à 17,4 milliards USD en 2022 et devrait atteindre environ 102,78 milliards USD d’ici 2032, avec un taux de croissance annuel composé de 19,43 % entre 2023 et 2032.

Prédiction 3 : D’ici 2027, 50 % des ingénieurs logiciels d’entreprise utiliseront des outils de codage alimentés par la ML, contre moins de 5 % aujourd’hui.

Déménagement de Sridevi Ramasamy

Sridevi : Il est évident que l’intégration des modèles d’IA et de ML directement dans le processus de développement des applications va fondamentalement remodeler la façon dont les entreprises fonctionnent et innovent.

L’un des aspects les plus convaincants de l’intégration des modèles d’IA et de ML dans le développement d’applications est leur potentiel à révolutionner l’analyse des données et la prédiction des tendances. En tirant parti de ces technologies, les entreprises peuvent extraire des informations précieuses de leurs données existantes, prendre des décisions éclairées et identifier les tendances émergentes dans leurs secteurs respectifs.

Bien que ce changement technologique représente une avancée significative, il est essentiel de reconnaître que cette transformation ne peut se faire du jour au lendemain. Le parcours vers la mise en œuvre efficace de l’IA et de la ML dans l’ingénierie logicielle nécessitera un apprentissage, une collaboration et une adaptation continus de la part des équipes d’ingénierie. Les outils de ML aident les développeurs à naviguer dans les complexités de l’intégration de l’IA et à s’assurer que les produits finaux sont robustes, efficaces et dotés de capacités de pointe.

Naresh : Pourriez-vous nous faire part de certains avantages ?

Sridevi : Bien sûr, Naresh. Permettez-moi de vous présenter quelques moyens par lesquels les organisations peuvent en tirer profit :

- Capacité de prise de décision

Les outils alimentés par le ML peuvent intégrer le traitement du langage naturel (NLP) pour comprendre et traiter les requêtes de recherche en langage naturel. Cette fonction permet aux développeurs de saisir des requêtes de recherche d’une manière très proche du langage humain, améliorant ainsi l’expérience globale de l’utilisateur.

La recherche avancée peut bénéficier de suggestions contextuelles générées par la ML. Ces suggestions peuvent inclure des exemples de code, des bibliothèques ou des fonctions en rapport étroit avec la requête, afin d’aider les développeurs à explorer différentes solutions.

- Croissance globale de l’activité

Les capacités prédictives des applications basées sur la ML renforcent considérablement la croissance de l’entreprise. Les organisations peuvent anticiper les tendances, les évolutions du marché et les comportements des clients. Forts de cette vision, ils peuvent adapter leurs stratégies de manière proactive afin de tirer parti des nouvelles opportunités et d’atténuer les risques potentiels. Quelques cas d’utilisation sont mentionnés ci-dessous :

- Recueillir les commentaires des utilisateurs et les analyses d’utilisation pour comprendre le fonctionnement des fonctions intégrées d’IA/ML.

- Permettre à l’application d’effectuer une inférence en temps réel en fournissant de nouvelles données aux modèles intégrés.

Grâce à l’utilisation de capacités de prise de décision et de prédiction basées sur les données, ces applications propulsent les stratégies d’entreprise vers des sommets sans précédent. En outre, le rôle des chefs de produit évolue, car les applications basées sur le ML suggèrent des caractéristiques de produit pour faciliter une croissance rapide.

Naresh : Comment les outils basés sur l’apprentissage automatique améliorent-ils la productivité des ingénieurs logiciels ?

Sridevi : En tirant parti de ces outils, les équipes d’ingénieurs peuvent exploiter la puissance de la ML, ce qui permet aux ingénieurs d’intégrer efficacement les capacités de ML dans leurs projets.

- Les outils de codage alimentés par le ML peuvent analyser le code et fournir des suggestions d’optimisation, telles que l’amélioration de l’efficacité des algorithmes, la réduction de l’utilisation de la mémoire et la minimisation de la consommation de ressources.

- Les outils de codage basés sur le ML peuvent automatiser les tâches répétitives et fastidieuses telles que la génération de code, l’achèvement et le débogage.

L’intégration de modèles d’IA/ML dans le développement d’applications nécessite une approche multidisciplinaire impliquant des développeurs, des scientifiques des données, des experts du domaine et des concepteurs UI/UX. Une intégration réussie peut déboucher sur des applications qui offrent des fonctionnalités améliorées, une meilleure expérience utilisateur et des informations fondées sur des données pour la prise de décision.

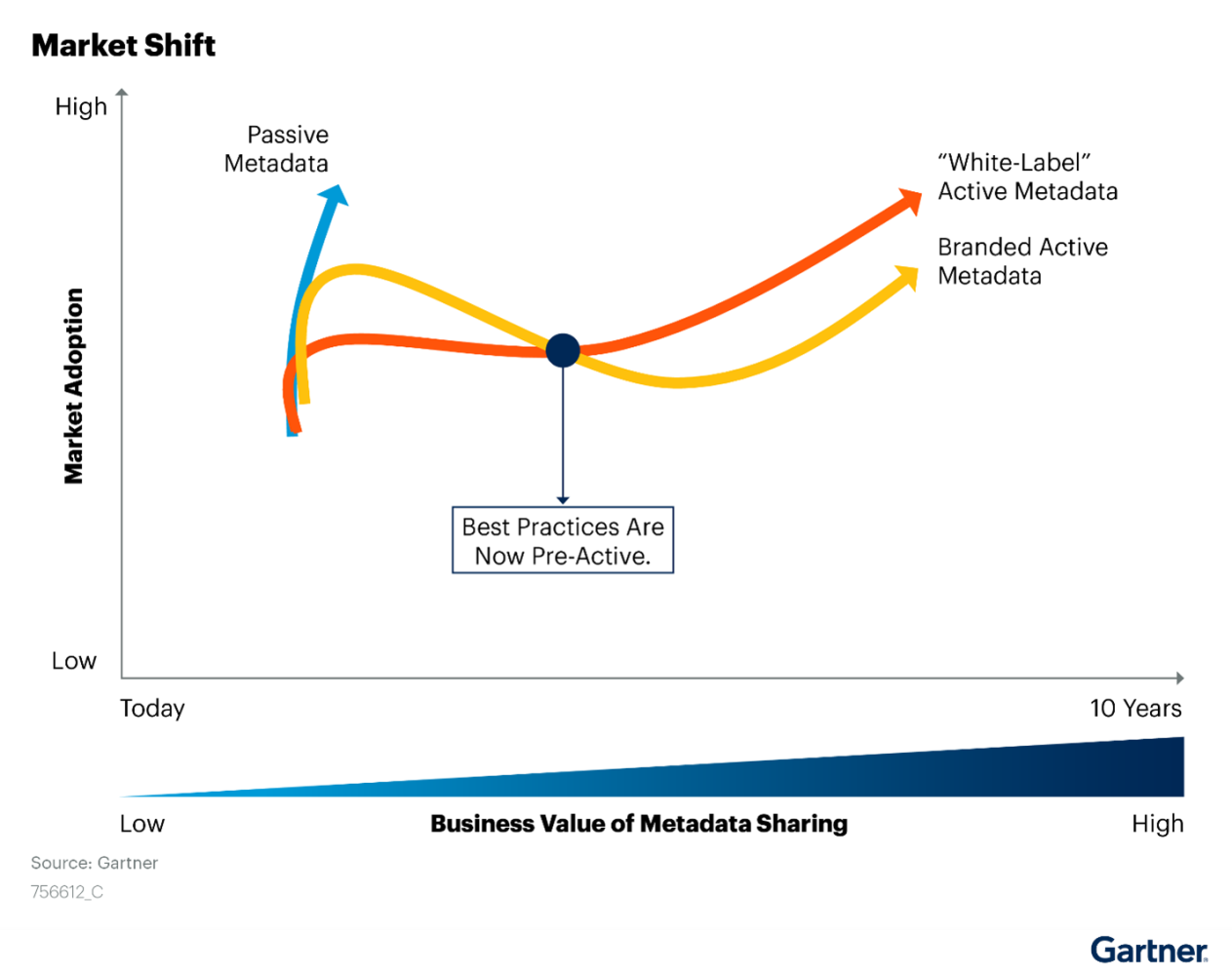

Prédiction 4 : D’ici 2026, les organisations qui adoptent des pratiques actives en matière de métadonnées passeront à 30 % pour accélérer l’automatisation, la découverte d’informations et les recommandations.

Déménagement de Rajkumar Purushothaman

Naresh : Pour les organisations qui envisagent d’adopter des pratiques actives en matière de métadonnées dans le domaine des données et de l’analyse, quels sont les défis ou les obstacles potentiels qu’elles pourraient rencontrer lors de la mise en œuvre ?

Raj : Eh bien, certains défis pourraient l’être :

- Silos de données

- Manque de cohérence/qualité des données

- Manque de précision des métadonnées

- Manque de faisabilité de l’intégration avec les outils d’analyse

Bien que chaque organisation soit confrontée à des défis différents, la plupart d’entre elles sont confrontées aux défis suivants.

Naresh : Pourriez-vous nous faire part de quelques bonnes pratiques qui peuvent aider à surmonter ces difficultés ?

Raj : Bien sûr, Naresh.

J’aimerais vous présenter les meilleures pratiques et les approches idéales pour surmonter les difficultés.

Défi 1 – Silos de données

Meilleures pratiques pour éliminer les silos de données

- Mettre en place un cadre unifié de gouvernance des données

- Utiliser des outils d’intégration de données pour relier des sources de données disparates.

- Appliquer des balises de métadonnées normalisées pour garantir la cohérence

L’approche idéale pour surmonter le défi

- Mettre en place une équipe centralisée de gouvernance des données chargée de créer et d’appliquer des normes en matière de métadonnées.

- Utilisez des outils de pointe tels qu’Informatica Metadata Manager pour créer un référentiel de métadonnées unifié.

- Normaliser les conventions de dénomination et les attributs de métadonnées entre les sources de données.

Défi 2 – Manque de cohérence/qualité des données

Bonnes pratiques pour garantir la qualité des données

- Mettre en œuvre des contrôles de qualité des données et des règles de validation

- Utiliser des métadonnées actives pour suivre l’évolution des paramètres de qualité des données.

- Établir les rôles et les responsabilités en matière de gestion des données

L’approche idéale pour surmonter le défi

- Mettre en œuvre des règles automatisées de qualité des données à l’aide d’outils standard.

- Déployez des déclencheurs de métadonnées actifs pour capturer les changements dans les métriques de qualité des données, tels que les enregistrements en double, les valeurs manquantes ou les valeurs aberrantes.

- Nommer des responsables des données chargés de contrôler et d’améliorer la qualité des données.

Défi 3 – Manque de précision des métadonnées

Meilleures pratiques

- Mettre en œuvre des processus automatisés de validation des métadonnées

- Utiliser le classement des données pour suivre les changements et l’exactitude du classement.

- Effectuer régulièrement des audits de métadonnées et des contrôles de qualité

L’approche idéale pour surmonter le défi

- Créez des processus automatisés qui valident les attributs de métadonnées par rapport à des règles prédéfinies, garantissant ainsi la cohérence et l’exactitude.

- Utilisez le suivi des données pour vérifier l’exactitude des métadonnées en les comparant au flux de données réel.

- Effectuer régulièrement des audits de la qualité des métadonnées afin d’identifier et de rectifier les incohérences ou les inexactitudes.

Défi 4 – Manque de faisabilité de l’intégration avec les outils d’analyse

Meilleures pratiques

- Choisissez des solutions de métadonnées qui s’intègrent aux plates-formes d’analyse les plus courantes.

- Développer des connecteurs de métadonnées pour un échange de données transparent

- Fournir la documentation et le soutien nécessaires à l’intégration des outils d’analyse

L’approche idéale pour surmonter le défi

- Choisissez des solutions de métadonnées qui s’intègrent à des plateformes d’analyse très répandues telles que Tableau et Power BI.

- Développer des connecteurs de métadonnées personnalisés pour permettre un échange de données transparent entre le référentiel de métadonnées et les outils d’analyse.

- Fournir une documentation claire et des guides d’utilisation pour aider les analystes à intégrer et à utiliser les métadonnées dans leurs flux de travail existants.

Naresh : Pourriez-vous nous expliquer quelques cas d’utilisation potentiels de l’automatisation à l’aide d’outils de métadonnées actives ?

Raj : C’est une bonne question.

Dans le processus d’automatisation des données et de l’analyse, les outils de métadonnées actives jouent un rôle crucial, et je souligne ici quelques cas d’utilisation.

- Ingestion et intégration automatisées des données

- Analyses et tableaux de bord en temps réel

- Contrôles automatisés de la qualité des données

- Le modèle prédictif se renouvelle

- Automatisation de l’analyse des données et de l’impact

Naresh : Pourriez-vous me présenter ces cas d’utilisation ?

Raj : Bien sûr, j’aimerais vous présenter quelques approches et solutions classiques pour chacun de ces cas d’utilisation.

Cas d’utilisation 1 – Ingestion et intégration automatisées des données

Approche :

Les outils de métadonnées actives surveillent en permanence les sources de données pour détecter les changements et déclencher des flux de travail automatisés d’ingestion et d’intégration. Ils capturent des métadonnées sur les formats de données, les structures et les relations afin de garantir une intégration précise et transparente des données.

Solution :

Utilisez des outils standard pour créer des pipelines de données qui automatisent les processus d’extraction, de transformation et de chargement (ETL). Les métadonnées actives suivent les changements et les attributs de métadonnées, garantissant ainsi l’intégration des données en temps réel à travers diverses sources.

Cas d’utilisation 2 – Analyses et tableaux de bord en temps réel

Approche :

Les métadonnées actives permettent des mises à jour en temps réel pour les tableaux de bord et les rapports analytiques en s’intégrant aux outils de visualisation. Il garantit que les tableaux de bord affichent les informations les plus récentes au fur et à mesure que les données changent.

Solution :

Utilisez des outils tels que Tableau ou Power BI pour créer des tableaux de bord dynamiques. Les métadonnées actives s’intègrent à ces outils et déclenchent des actualisations automatiques des données lorsque les données sous-jacentes changent. Cette approche garantit que les décideurs ont accès à des informations de dernière minute.

Cas d’utilisation 3 – Contrôles automatisés de la qualité des données

Approche :

Les métadonnées actives collaborent avec les outils de qualité des données pour déclencher des contrôles automatisés de la qualité des données sur la base de règles prédéfinies. Il capture des métadonnées sur les mesures de qualité des données et les anomalies.

Solution :

Utiliser des outils de qualité des données standard comme Informatica Data Quality. Les métadonnées actives interagissent avec les outils pour lancer des processus automatisés de validation des données, garantissant ainsi l’exactitude et la cohérence des données.

Cas d’utilisation 4 – Actualisation du modèle prédictif

Approche :

Les métadonnées actives surveillent les changements dans les données d’entrée et déclenchent un recyclage automatisé des modèles prédictifs. Il capture des métadonnées sur les versions du modèle et les dépendances des données.

Solution :

Utiliser des plateformes d’apprentissage automatique comme TensorFlow, scikit-learn, ou des offres natives du cloud. Les métadonnées actives détectent les changements de données, déclenchent le recyclage du modèle et mettent à jour les métadonnées pour refléter les dernières versions du modèle, garantissant ainsi des prédictions précises.

En utilisant ces approches et les principaux outils de métadonnées actives, les organisations peuvent parvenir à une automatisation efficace et efficiente de divers processus de données et d’analyse. Ces outils améliorent l’agilité, la précision et la prise de décision en exploitant la puissance des métadonnées actives.

Cet article a été publié à l’origine dans notre lettre d’information LinkedIn, ZtoA Pulse.

Vous souhaitez entrer en contact avec nos experts ? Laissez-nous vos coordonnées et nous vous contacterons.