Welkom bij de tweede editie van het tweede seizoen van ZtoA Pulse.

In dit digitale tijdperk, waarin elke toetsaanslag en transactie gegevens genereert, is het van cruciaal belang om de kracht ervan te benutten. In het hart van deze transformatie ligt de samensmelting van inzichten en expertise, waar de pioniers van kennis en de pioniers van technologie elkaar kruisen. Dat is precies wat deze editie inhoudt: een nieuwsbrief die de expertise van de thought leaders van Zuci Systems combineert met inzichten uit een van de recente data- en analyserapporten van Gartner.

Met een scherpe blik op de horizon hebben we deze nieuwsbrief samengesteld om de toekomst van data & analytics te decoderen met behulp van de lenzen die Gartner biedt. Hun recente rapport, “Over 100 Data and Analytics Predictions Through 2028” (link hieronder), fungeert als een baken voor organisaties om hun data en analytics framework fool-proof te maken.

Deze nieuwsbrief duikt diep in vier voorspellingen, zoekt de inzichten van onze experts en ontrafelt de lagen om het discours te verrijken. Samen zullen we aannames ter discussie stellen, gesprekken op gang brengen en een brug slaan tussen de theoretische en praktische facetten van Gartner’s data- en analysevoorspellingen.

Even voorstellen: de experts van Zuci System:

1) Kalyan Allam

Hallo allemaal, ik ben Naresh Kumar, Lead Marketing Strategist bij Zuci Systems. Laten we ons verdiepen in de vier voorspellingen van Gartner die helpen om de data- en analytics-game van organisaties vorm te geven!

Voorspelling 1 – Tegen 2026 zal 50% van de BI-tools de metadata van hun gebruikers activeren en inzichten en gegevensverhalen aanbieden met aanbevolen gecontextualiseerde trajecten en acties.

Verhuizen naar Kalyan Allam

Naresh: Wat zijn de belangrijkste voordelen die organisaties en gebruikers kunnen verwachten van BI-tools die aanbevolen gecontextualiseerde journeys en acties bieden?

Kalyan: Normaal gesproken zoeken besluitvormers voortdurend naar antwoorden op steeds terugkerende vragen, terwijl de gegevens zelf voortdurend veranderen. Het verhaal dat ze proberen op te bouwen uit de gegevens verandert naarmate de omstandigheden zich ontwikkelen. De wens om inzichten op maat te verkrijgen is dus moeilijk te realiseren voor organisaties.

Het blijft echter een obstakel om deze inzichten uit verschillende gegevensbronnen te halen. Dergelijke moeilijkheden blijven bestaan omdat elke persoon een bepaalde set gegevens op zijn eigen manier begrijpt, wat resulteert in verschillende verhalen. Dit scenario benadrukt het belang van geïndividualiseerde inzichten, die ongelooflijk waardevol zijn. Om dit doel te bereiken, moeten organisaties de metadata van gebruikers verzamelen.

Het is essentieel om systemen te ontwikkelen die het analytische traject van gebruikers documenteren en de intentie achter elk onderzoek begrijpen. Dit concept van actorgebaseerde analytics zal organisaties op veel manieren ten goede komen.

Naresh: Kunt u toelichten hoe organisaties profiteren van op actoren gebaseerde analyses en inzichten op maat?

Natuurlijk, Naresh. Dat is een uitstekende vraag.

Enkele manieren waarop organisaties kunnen profiteren van actorgebaseerde analytics en inzichten op maat zijn:

1. Verhoogde betrokkenheid van gebruikers: Het verschaffen van op maat gemaakte inzichten zorgt voor een hogere mate van betrokkenheid onder gebruikers, waardoor ze worden verleid om actief deel te nemen en vaker te communiceren met de business intelligence (BI) tool. Deze grotere betrokkenheid komt voort uit de relevantie en specificiteit van de inzichten, die beter aansluiten bij de individuele behoeften en doelstellingen van gebruikers.

2. Verminderde cognitieve overbelasting: Door gepersonaliseerde inzichten te leveren, verminderen organisaties de cognitieve belasting door informatie te leveren die precies is afgestemd op de interesses van gebruikers. Met deze aanpak kunnen gebruikers hun aandacht richten op besluitvormingsprocessen.

3. Geoptimaliseerde toewijzing van middelen: Inzicht krijgen in het analytische traject van gebruikers stelt organisaties in staat om middelen toe te wijzen voor een optimaal rendement. Door de patronen en voorkeuren te onderscheiden die uit gebruikersinteracties naar voren komen, kunnen organisaties investeringen kanaliseren naar gebieden die de grootste impact en waarde beloven, waardoor de efficiëntie wordt verhoogd en het gebruik van middelen wordt gemaximaliseerd.

Naresh: Hoe identificeren deze BI-tools relevante gecontextualiseerde trajecten en acties voor gebruikers en hoe doen ze aanbevelingen? Welke algoritmen of methodologieën worden vaak gebruikt om inzichten af te stemmen op individuele behoeften?

Kalyan: Momenteel is er een gat in de beschikbaarheid van kant-en-klare oplossingen die gebruikers inzichten op maat kunnen bieden. Om een gecontextualiseerde reis binnen business intelligence tools (BI) te identificeren en gebruikers op maat gemaakte inzichten te bieden, is het tijdrovend om je te concentreren op twee cruciale aspecten.

Naresh: Kunt u de twee aspecten met ons doornemen?

Kalyan: Ten eerste is het van vitaal belang om de metadata van gebruikers vast te leggen. Dit houdt in dat informatie moet worden verzameld over de rollen en verantwoordelijkheden van de gebruiker, de specifieke gegevenssets waartoe hij toegang heeft en de vragen die hij stelt. Door deze elementen holistisch vast te leggen, kunnen organisaties een uitgebreid beeld vormen van individuele gebruikersprofielen, waardoor inzichten kunnen worden gecreëerd die direct aansluiten bij hun unieke behoeften en vereisten.

Ten tweede kan de convergentie van machine learning (ML) technologieën (met name Large Language Models zoals OpenAI’s GPT en LLM’s aangeboden door platforms zoals Hugging Face) met BI-tools zoals Tableau of Power BI het proces vergemakkelijken. Deze LLM’s hebben het opmerkelijke vermogen om de reis van gebruikers in hun context te plaatsen door hun specifieke eisen en intenties vast te leggen. Om dit model operationeel te maken, moeten organisaties een systeem opzetten waarin de analytische reis begint met prompts. Deze op prompts gebaseerde aanpak vergemakkelijkt het vastleggen van metadata van gebruikers, waardoor het systeem voortdurend kan leren en zijn inzichten kan verfijnen op basis van de evoluerende interactiepatronen van gebruikers.

Door gebruik te maken van deze strategieën kunnen organisaties de weg vrijmaken voor een transformatieve benadering van gepersonaliseerde inzichten, het integreren van geavanceerde ML-technologieën en BI-tools en uiteindelijk het verbeteren van de gebruikerservaring door precies op maat gemaakte analytische oplossingen te bieden.

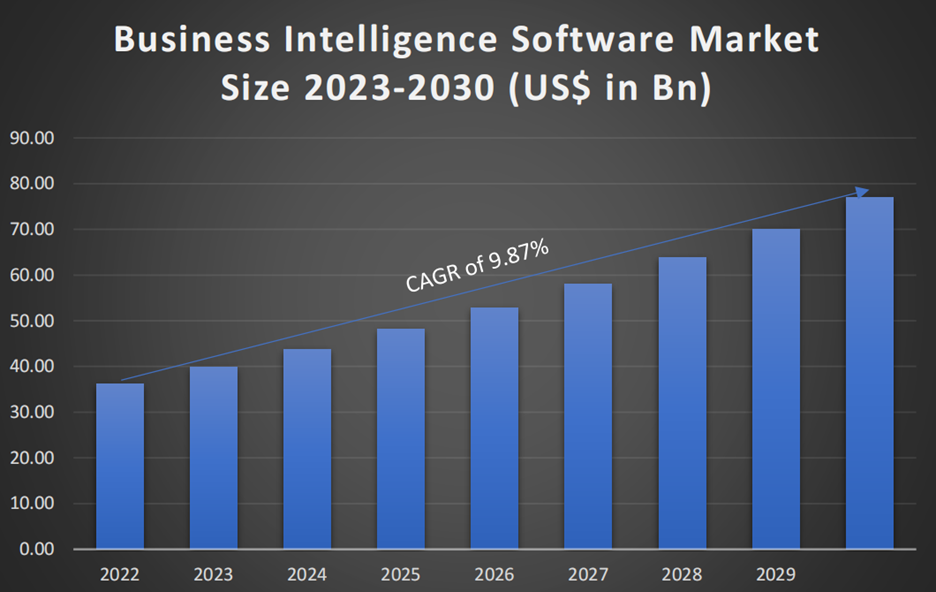

Volgens SNS Insider Research werd de omvang van de Business Intelligence Software Markt gewaardeerd op US$ 36,27 miljard in 2022 en zal deze naar verwachting US$ 77,03 miljard bereiken in 2030, met een gezonde groei van de CAGR van 9,87% gedurende de prognoseperiode 2023-2030.

Voorspelling 2: In 2026 zal meer dan 60% van de TDIR-mogelijkheden (threat detection, investigation and response) gebruikmaken van blootstellingsbeheergegevens om gedetecteerde bedreigingen te valideren en er prioriteit aan te geven, terwijl dat nu minder dan 5% is.

Verhuizen naar Janarthanan Poornavel

Naresh: Hoe spelen AI en ML een rol bij het analyseren van gegevens over blootstellingsbeheer voor detectie en reactie op bedreigingen? Wat zijn de belangrijkste algoritmen en technieken voor machinaal leren die in deze context worden gebruikt?

Jana: Ik wil graag een van de succesverhalen naar voren brengen over de naadloze integratie van AI en ML, met betrekking tot het beheer van blootstellingsgegevens en TDIR, in een van onze recente projecten om de complexe uitdaging van fraude met bankcheques te bestrijden.

Gezien het np-harde probleem was het vinden van een perfecte oplossing in een redelijke tijd een ongelofelijke uitdaging. In ons geval werd de complexiteit verergerd door de exponentiële toename van het aantal transacties. Je kunt je voorstellen dat alleen al het aantal transacties dat geanalyseerd moet worden, traditionele benaderingen snel overweldigt, waardoor het moeilijk wordt om mogelijk frauduleuze activiteiten te detecteren waarbij transactiegeschiedenis, rekeninggedrag en patronen een rol spelen.

De integratie van AI en ML hielp ons echter om enorme hoeveelheden gegevens te analyseren, patronen te herkennen en ons aan te passen aan veranderende bedreigingen, waardoor we een formidabel verdedigingsmechanisme tegen chequefraude konden creëren. Met de succesvolle implementatie van bedreigingsdetectie op basis van blootstellingsbeheer beoordeelden AI-algoritmen snel transactiegedrag om afwijkingen te identificeren die zouden kunnen wijzen op frauduleuze activiteiten gericht op “x aantal” peso’s.

Naresh: Jana, je hebt inzicht gegeven in hoe AI en ML werden toegepast om het scenario van chequefraude aan te pakken. Kunt u uitleggen hoe Machine Learning mogelijke oplossingen biedt voor het beheer van blootstellingsgegevens in de context van bedreigingsdetectie?

Natuurlijk, Naresh. Machine Learning biedt robuuste oplossingen voor het opsporen van bedreigingen. Ik zal een paar cruciale aspecten uitsplitsen, namelijk patroonherkenning en anomaliedetectie.

- Patroonherkenning: Machine Learning-algoritmen blinken uit in patroonherkenning. Door strenge training op een diverse dataset van handgeschreven cheques worden de ML-modellen bedreven in het onderscheiden van legitieme en frauduleuze wijzigingen. Deze verbeterde patroonherkenning vergroot onze gevoeligheid voor zelfs de meest subtiele afwijkingen.

- Anomaliedetectie: ML gedijt bij het detecteren van anomalieën: onregelmatigheden die met traditionele methoden misschien niet worden opgemerkt. Gegevens over blootstellingsbeheer bevatten een schat aan contextuele informatie. We maken gebruik van ML-algoritmen om verborgen correlaties en afwijkingen te ontdekken die duiden op potentiële bedreigingen.

Naresh: Jana, jouw succesverhaal benadrukt de kracht van AI en ML bij het opsporen van bedreigingen. Kunt u me enkele specifieke manieren vertellen waarop AI en ML de weg hebben vrijgemaakt voor dit succes?

Jana: Dat is een uitstekende vraag.

Geavanceerde Deep Learning-algoritmen en Inference Service Stack hebben een belangrijke rol gespeeld bij het detecteren van fraude. Laat me je stap voor stap helpen:

Stap 1 – Ons team gebruikte geavanceerde deep learning-algoritmen om deze complexe uitdaging aan te gaan. Deze geavanceerde algoritmen, aangedreven door machine learning, herkennen patronen en anomalieën in enorme datasets. Door deze modellen te trainen op een breed scala aan handgeschreven cheques konden we de gevoeligheid en specificiteit verbeteren, waardoor zelfs de meest subtiele frauduleuze wijzigingen konden worden geïdentificeerd.

Stap 2 – Aangezien de bank meer dan 1000 filialen heeft, hebben we een innovatieve inferentieservice opgezet om deze chequefraude in alle filialen te minimaliseren. Dankzij deze architectuur konden we een enorm volume aan controles efficiënt verwerken en de mogelijkheden van onze deep learning-modellen maximaliseren. De combinatie van AI en efficiënte infrastructuur bleek een winnende formule.

Naresh: Dat is een slimme aanpak, Jana. Het is indrukwekkend hoe jullie gebruik hebben gemaakt van geavanceerde algoritmen en een schaalbare infrastructuur om de uitdaging effectief aan te gaan.

Jana: In de context van de analyse van blootstellingsbeheergegevens voor het opsporen van bedreigingen en het reageren op fraude met cheques, hebben AI en ML zich bewezen als transformerende katalysatoren. Onze deep learning, doordrenkt met de kracht van machine learning-algoritmen (Yolo en Faster CNN), stelt ons in staat om frauduleuze patronen met ongekende nauwkeurigheid te onderscheiden. Bovendien zorgt onze geavanceerde inference service stack ervoor dat deze geavanceerde technologie efficiënt over het netwerk kan worden ingezet.

Nou, Naresh, tot slot sluit ik me aan bij de inzichten van Gartner in het zich ontwikkelende landschap van bedreigingsdetectie. Hun voorspelling dat tegen 2026 meer dan 60% van de bedreigingsdetectiemogelijkheden gebruik zal maken van blootstellingsbeheergegevens, sluit aan bij onze aanpak. Door gegevens over blootstellingsbeheer op te nemen, voorzie ik een indrukwekkende groei van 15% verbetering in de TDIR, die vandaag 5% bedraagt.

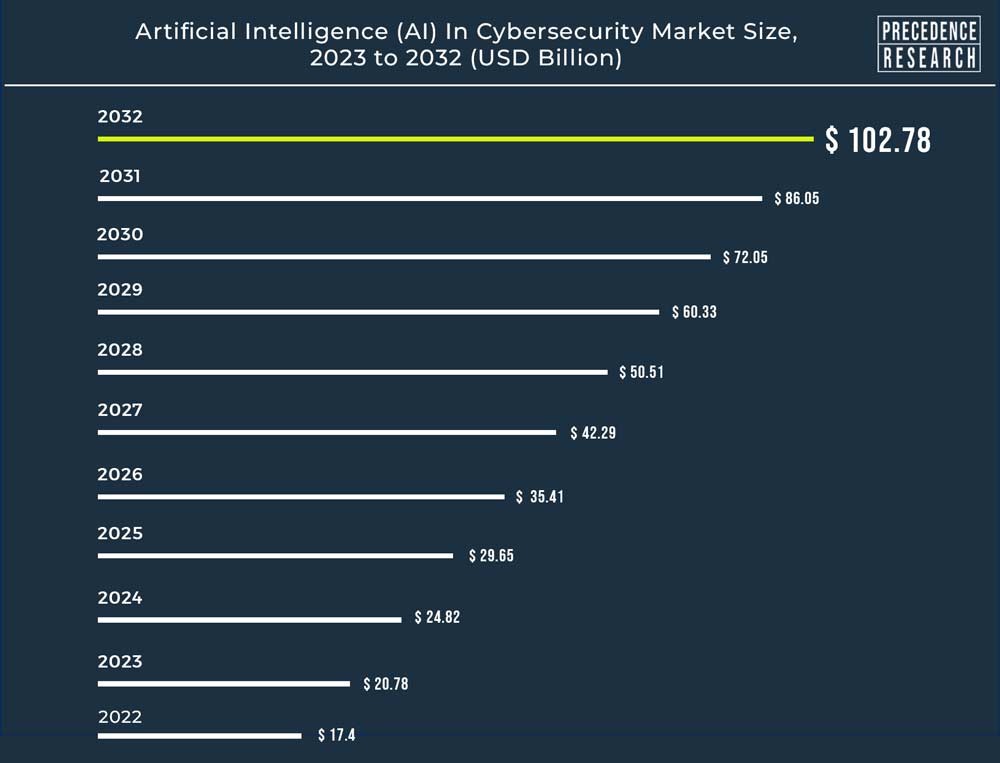

De wereldwijde markt voor kunstmatige intelligentie (AI) in cyberbeveiliging werd in 2022 geschat op 17,4 miljard dollar en zal naar verwachting 102,78 miljard dollar bedragen in 2032, met een groei van 19,43% tussen 2023 en 2032.

Voorspelling 3: In 2027 zal 50% van de software-engineers in bedrijven ML-ondersteunde codeertools gebruiken, tegenover minder dan 5% nu.

Verhuizen naar Sridevi Ramasamy

Sridevi: Het is duidelijk dat de integratie van AI- en ML-modellen direct in het applicatieontwikkelingsproces de manier waarop bedrijven werken en innoveren fundamenteel zal veranderen.

Een van de meest aantrekkelijke aspecten van het integreren van AI- en ML-modellen in applicatieontwikkeling is hun potentieel om een revolutie teweeg te brengen in gegevensanalyse en trendvoorspelling. Door gebruik te maken van deze technologieën kunnen bedrijven waardevolle inzichten uit hun bestaande gegevens halen, weloverwogen beslissingen nemen en opkomende trends in hun sector identificeren.

Hoewel deze technologische verschuiving een aanzienlijke vooruitgang betekent, is het essentieel om te erkennen dat deze transformatie niet van de ene op de andere dag kan plaatsvinden. De reis naar het effectief implementeren van AI en ML in software engineering vereist voortdurend leren, samenwerking en aanpassing van engineering teams. ML-tools helpen ontwikkelaars bij het navigeren door de complexiteit van AI-integratie en zorgen ervoor dat de eindproducten robuust en efficiënt zijn en uitgerust met geavanceerde mogelijkheden.

Naresh: Kun je wat voordelen delen?

Sridevi: Natuurlijk, Naresh. Laat me een paar manieren schetsen waarop organisaties hier voordeel uit kunnen halen:

- Vermogen om beslissingen te nemen

ML-tools kunnen Natural Language Processing (NLP) bevatten om zoekopdrachten in natuurlijke taal te begrijpen en te verwerken. Met deze functie kunnen ontwikkelaars zoekopdrachten invoeren op een manier die sterk lijkt op menselijke taal, waardoor de algehele gebruikerservaring wordt verbeterd.

Geavanceerd zoeken kan profiteren van ML-gegenereerde contextuele suggesties. Deze suggesties kunnen relevante codevoorbeelden, bibliotheken of functies bevatten die nauw verband houden met de zoekopdracht, zodat ontwikkelaars verschillende oplossingen kunnen verkennen.

- Totale bedrijfsgroei

De voorspellende mogelijkheden van ML-toepassingen versterken de bedrijfsgroei aanzienlijk. Organisaties kunnen anticiperen op trends, marktverschuivingen en klantgedrag. Gewapend met deze vooruitziende blik kunnen ze proactief strategieën aanpassen om in te spelen op nieuwe kansen en potentiële risico’s te beperken. Hieronder worden enkele use cases genoemd:

- Verzamel feedback van gebruikers en gebruiksanalyses om te begrijpen hoe goed de geïntegreerde AI/ML-functies werken.

- Stel de applicatie in staat om real-time inferentie uit te voeren door nieuwe gegevens te voeden aan de geïntegreerde modellen.

Door het gebruik van gegevensgestuurde besluitvorming en voorspellende mogelijkheden stuwen deze toepassingen bedrijfsstrategieën naar ongekende hoogten. Daarnaast evolueert de rol van Product Managers naarmate ML-gestuurde apps producteigenschappen voorstellen om snelle groei mogelijk te maken.

Naresh: Hoe verbeteren tools die gebruik maken van machine learning de productiviteit van software engineers?

Sridevi: Door gebruik te maken van deze tools kunnen engineeringteams de kracht van ML benutten, zodat ingenieurs ML-mogelijkheden effectief in hun projecten kunnen opnemen.

- Coderingstools die gebruik maken van ML kunnen code analyseren en suggesties doen voor optimalisatie, zoals het verbeteren van de efficiëntie van algoritmes, het verminderen van geheugengebruik en het minimaliseren van het gebruik van bronnen.

- Coderingstools die gebruik maken van ML kunnen repetitieve en tijdrovende taken automatiseren, zoals code genereren, voltooien en debuggen.

Het integreren van AI/ML-modellen in de ontwikkeling van applicaties vereist een multidisciplinaire aanpak waarbij ontwikkelaars, datawetenschappers, domeinexperts en UI/UX-ontwerpers betrokken zijn. Succesvolle integratie kan leiden tot applicaties die verbeterde functionaliteit, betere gebruikerservaringen en gegevensgedreven inzichten voor besluitvorming bieden.

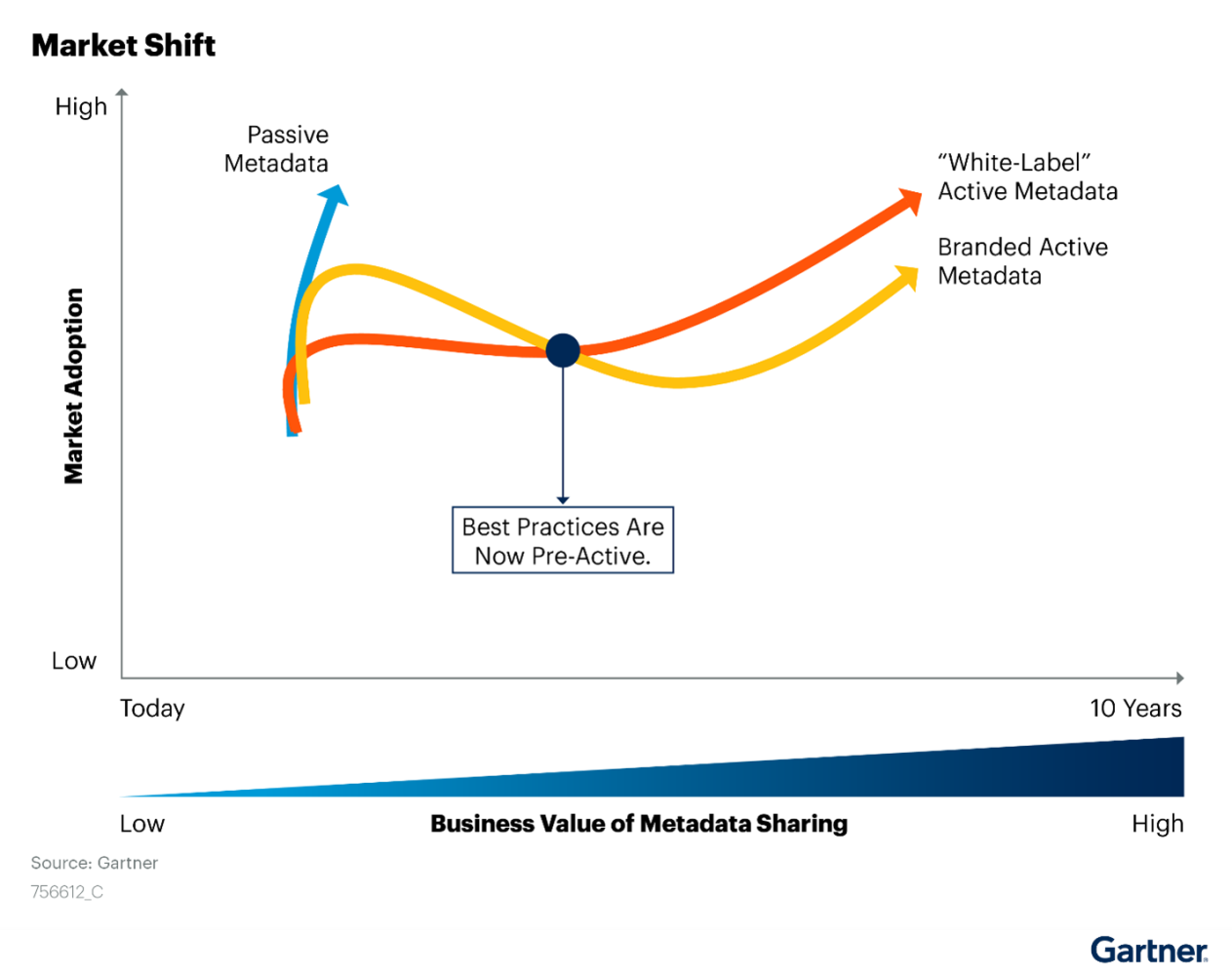

Voorspelling 4: Tegen 2026 zal het aantal organisaties dat actief metadata gebruikt toenemen tot 30% om automatisering, het ontdekken van inzichten en aanbevelingen te versnellen.

Verhuizen naar Rajkumar Purushothaman

Naresh: Voor organisaties die overwegen om actieve metadata in te voeren in data en analyse, wat zijn de mogelijke uitdagingen of hindernissen die ze tegen kunnen komen tijdens de implementatie?

Raj: Nou, sommige uitdagingen zouden dat kunnen zijn:

- Datasilo’s

- Gebrek aan consistentie/kwaliteit van gegevens

- Gebrek aan nauwkeurigheid van metadata

- Integratie met analysetools is niet haalbaar

Hoewel elke organisatie andere uitdagingen tegenkomt, zijn dit enkele kritieke uitdagingen waar de meeste organisaties mee te maken krijgen.

Naresh: Kunt u enkele best practices delen die kunnen helpen deze uitdagingen te overwinnen?

Natuurlijk, Naresh.

Ik wil dit graag uitsplitsen in best practices en ideale benaderingen om de uitdagingen te overwinnen.

Uitdaging 1 – Datasilo’s

Best Practices om datasilo’s te elimineren

- Een uniform raamwerk voor data governance implementeren

- Tools voor gegevensintegratie gebruiken om ongelijksoortige gegevensbronnen met elkaar te verbinden

- Gebruik gestandaardiseerde metadatatags om consistentie te garanderen

Ideale aanpak om de uitdaging aan te gaan

- Richt een gecentraliseerd data governance team op om metadatastandaarden te maken en te handhaven.

- Gebruik toonaangevende tools zoals Informatica Metadata Manager om een uniforme metadatarepository te maken.

- Standaardiseer naamgevingsconventies en metadata-attributen voor verschillende gegevensbronnen.

Uitdaging 2 – Gebrek aan consistentie/kwaliteit van gegevens

Best Practices om datakwaliteit te garanderen

- Datakwaliteitscontroles en validatieregels implementeren

- Actieve metadata gebruiken om veranderingen in gegevenskwaliteit bij te houden

- Rollen en verantwoordelijkheden voor gegevensbeheer vastleggen

Ideale aanpak om de uitdaging aan te gaan

- Geautomatiseerde regels voor gegevenskwaliteit implementeren met behulp van standaardtools.

- Gebruik actieve metadata triggers om veranderingen in gegevenskwaliteit vast te leggen, zoals dubbele records, ontbrekende waarden of uitschieters.

- Benoem data stewards die verantwoordelijk zijn voor het bewaken en verbeteren van de datakwaliteit.

Uitdaging 3 – Gebrek aan nauwkeurigheid van metadata

Beste praktijken

- Geautomatiseerde processen voor metadatavalidatie implementeren

- Data lineage gebruiken om wijzigingen en de nauwkeurigheid van lineage bij te houden

- Regelmatige metadata-audits en kwaliteitscontroles uitvoeren

Ideale aanpak om de uitdaging aan te gaan

- Creëer geautomatiseerde processen die metadata attributen valideren aan de hand van vooraf gedefinieerde regels, om consistentie en nauwkeurigheid te garanderen.

- Gebruik data lineage tracking om de nauwkeurigheid van metadata te verifiëren door deze te vergelijken met de daadwerkelijke datastroom.

- Voer regelmatig kwaliteitscontroles uit op metadata om inconsistenties of onnauwkeurigheden te identificeren en te corrigeren.

Uitdaging 4 – Onmogelijkheid tot integratie met analysetools

Beste werkwijze

- Kies metadata-oplossingen die integreren met populaire analyseplatforms

- Metadata-connectors ontwikkelen voor naadloze gegevensuitwisseling

- Zorg voor documentatie en ondersteuning voor de integratie van analysetools

Ideale aanpak om de uitdaging aan te gaan

- Kies metadata-oplossingen die integreren met veelgebruikte analyseplatforms zoals Tableau en Power BI.

- Aangepaste metadataconnectors ontwikkelen om naadloze gegevensuitwisseling mogelijk te maken tussen de metadatarepository en analysetools.

- Duidelijke documentatie en gebruikershandleidingen bieden om analisten te helpen metadata te integreren en te gebruiken binnen hun bestaande workflows.

Naresh: Kun je enkele potentiële automatiseringsgebruiksgevallen uitleggen die gebruikmaken van actieve metadatatools?

Raj: Dat is een goede vraag.

In het automatiseringsproces voor gegevens en analyse spelen actieve metadatatatools een cruciale rol, en ik belicht hier enkele use cases.

- Geautomatiseerde gegevensinvoer en -integratie

- Real-Time Analytics en Dashboards

- Geautomatiseerde controles van gegevenskwaliteit

- Voorspellend model vernieuwt

- Geautomatiseerde datalijn en impactanalyse

Naresh: Kun je deze use cases met me doornemen?

Raj: Natuurlijk, ik wil graag enkele klassieke benaderingen en oplossingen voor elk van deze use cases met u delen.

Use Case 1 – Geautomatiseerde gegevensinvoer en -integratie

Aanpak:

Actieve metadatatools controleren gegevensbronnen voortdurend op wijzigingen en activeren geautomatiseerde opname- en integratieworkflows. Ze leggen metadata vast over gegevensindelingen, -structuren en -relaties om een nauwkeurige en naadloze gegevensintegratie te garanderen.

Oplossing:

Gebruik tools die in de branche gebruikelijk zijn om datapijplijnen te maken die de extractie-, transformatie- en laadprocessen (ETL) automatiseren. Actieve metadata houdt wijzigingen en metadata-attributen bij en zorgt zo voor real-time gegevensintegratie tussen verschillende bronnen.

Use Case 2 – Real-Time Analytics en Dashboards

Aanpak:

Actieve metadata maakt real-time updates mogelijk voor analytische dashboards en rapporten door integratie met visualisatietools. Het zorgt ervoor dat dashboards de meest actuele inzichten weergeven wanneer gegevens veranderen.

Oplossing:

Maak gebruik van tools zoals Tableau of Power BI om dynamische dashboards te bouwen. Actieve metadata integreert met deze tools, waardoor gegevens automatisch worden vernieuwd wanneer de onderliggende gegevens veranderen. Deze aanpak zorgt ervoor dat besluitvormers toegang hebben tot actuele inzichten.

Use Case 3 – Geautomatiseerde controles van gegevenskwaliteit

Aanpak:

Actieve metadata werkt samen met tools voor gegevenskwaliteit om geautomatiseerde controles van de gegevenskwaliteit te activeren op basis van vooraf gedefinieerde regels. Het legt metadata vast over datakwaliteitsmetingen en anomalieën.

Oplossing:

Gebruikmaken van industriestandaard tools voor datakwaliteit, zoals Informatica Data Quality. Actieve metadata werken samen met de tools om geautomatiseerde gegevensvalidatieprocessen te starten, waardoor de nauwkeurigheid en consistentie van de gegevens wordt gegarandeerd.

Use Case 4 – Voorspellend model vernieuwen

Aanpak:

Actieve metadata bewaakt veranderingen in gegevensinvoer en triggert automatische hertraining van voorspellende modellen. Het legt metadata vast over modelversies en gegevensafhankelijkheden.

Oplossing:

Maak gebruik van machine learning-platforms zoals TensorFlow, scikit-learn of cloud native aanbiedingen. Actieve metadata detecteert veranderingen in de gegevens, activeert de hertraining van het model en werkt de metadata bij met de nieuwste modelversies, waardoor nauwkeurige voorspellingen worden gegarandeerd.

Door deze benaderingen en toonaangevende actieve metadatatools te gebruiken, kunnen organisaties een efficiënte en effectieve automatisering van verschillende data- en analyseprocessen bereiken. Deze tools verbeteren de wendbaarheid, nauwkeurigheid en besluitvorming door gebruik te maken van de kracht van actieve metadata.

Oorspronkelijk gepubliceerd in onze LinkedIn nieuwsbrief, ZtoA Pulse.

Wil je in contact komen met onze experts? Laat je gegevens achter en we nemen contact met je op.